题目:Vision-Language Pre-Training for Multimodal Aspect-Based Sentiment Analysis

会议:ACL 2022 Main Conference

作者:凌焱,虞剑飞,夏睿

单位:南京理工大学

论文链接:http://arxiv.org/abs/2204.07955

代码链接:https://github.com/NUSTM/VLP-MABSA

引言

近年来,多模态属性级情感分析任务(Multimodal Aspect-Based Sentiment Analysis, MABSA)受到了越来越广泛的关注。给定一个图像-文本对,该任务主要包含三个子任务:

多模态属性词抽取(Multimodal Aspect Term Extraction, MATE),其旨在抽取文本中提及的所有属性词。

多模态属性级情感分类(Multimodal Aspect-oriented Sentiment Classification, MASC),其旨在对每个文本中提及的属性词进行情感分类。

多模态属性情感联合分析(Joint Multimodal Aspect-Sentiment Analysis, JMASA),其旨在同时进行属性词的抽取和情感分类。

例如,给定下表中的多模态推文,JMASA任务的目标为抽取出所有的属性-情感对,如(Sergio,积极),(UCL,中立)。

现有的大部分多模态属性级情感分析方法主要集中于利用预训练的单模态模型(如使用BERT获得文本表示,使用ResNet获得图像表示)来获取文本模态和图像模态的特征。但是这种对图像文本独立预训练的方式忽略了文本和图像间的对齐。因此,如何利用多模态预训练的方式来获取跨模态的对齐是值得深入研究的。

最近,有少数工作提出对多模态属性级情感分析任务进行多模态预训练。但是这些工作主要使用了通用的预训练任务,如图像-文本对齐任务和掩码语言模型任务。这些通用的预训练任务不足以挖掘细粒度的属性、观点信息以及它们在图像和文本模态间的对齐信息。

为了解决上述问题,我们针对多模态属性级情感分析任务,提出了一个任务特定的视觉-语言预训练模型(VLP-MABSA)。具体来说,首先我们为预训练和下游任务构建了一个通用的基于BART的多模态生成式框架,然后我们设计了三类共5项视觉-语言预训练任务:

文本模态预训练:1)掩码语言模型;2)文本属性-观点抽取。

视觉模态预训练:1)掩码区域模型;2)视觉属性-观点生成。

多模态预训练:1)多模态情感预测。

其中文本模态预训练和视觉模态预训练均包含一个通用的预训练任务和一个任务特定的预训练任务,分别用于获取通用的模态对齐信息和两个模态细粒度的属性-观点信息。多模态预训练任务设计为多模态情感预测。我们将文本和视觉模态中的属性视为一种客观信息,观点视为一种主观信息。在多模态预训练中,两个模态细粒度的主客观信息充分耦合、互相关联, 主观信息依赖于客观信息,客观信息也能从主观信息中得到暗示。综合进行这三类预训练任务可以很好地获取图像和文本模态中对于多模态属性级情感分析任务重要的细粒度主客观信息以及两者的对齐信息,从而有助于多模态细粒度情感分析任务性能的提升。

x.003.png)

实验结果表明我们提出的预训练模型(VLP-MABSA)在多模态属性级情感分析的三项子任务上与当前方法相比取得了领先的性能。如在JMASA任务上,相比于目前性能最优的方法JML,VLP-MABSA在TWITTER-2015和TWITTER-2017两个benchmark数据集上的F1值分别提升了2.5和2.0个百分点。

方法

图1展示了我们模型的整体框架。框架的backbone是BART,我们将其扩展到文本和图像的多模态输入,通过解码的方式来进行预训练任务和下游任务。

特征提取器

图像表示:我们采用Faster R-CNN来抽取图像的区域特征,然后仅保留置信度最高的36个区域,并使用一个线性层将其映射到和文本特征相同的维度。

文本表示:对文本进行tokenize操作,并送入到BART的嵌入矩阵中进行映射。

基于BART的生成式框架

编码器:结构为多层双向Transformer,我们使用<img>和</img>来指示图像特征的开端和结尾,使用<bos>和<eos>来指示文本特征的开端和结尾。

解码器:结构也为多层的Transformer,但在生成过程中是单向自回归形式。由于所有的预训练任务共享同一个解码器,我们在解码器的输入端插入两个特殊的token去指示不同的预训练任务。<bos>指示生成过程的开始,另外一个用于指示任务类别,如<mlm>表示掩码语言模型,<mrm>表示掩码区域模型。

预训练任务

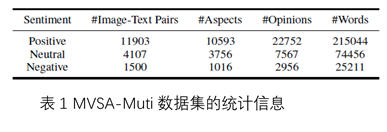

我们使用的预训练数据集为MVSA-Multi,是多模态Twitter情感分析领域常用的数据集。提供了图像-文本对以及图像-文本对上的整体情感标签。基于这个数据集,我们设计了三类预训练,包括文本模态预训练,视觉模态预训练和多模态预训练。

文本模态预训练

− 掩码语言模型(Masked Language Modeling, MLM)

![]()

随机mask文本输入中15%的token,该任务的目标是基于掩码后的多模态特征生成原始的完整文本。

− 文本属性-观点抽取(Textual Aspect-Opinion Extraction,AOE)

该任务旨在结合文本和图像抽取文本中提及的属性词和观点词。针对预训练数据集我们采用了以下方法来获取监督信息。

属性词:我们使用了一个现有的Twitter命名实体识别(Named Entity Recognition, NER)工具,对数据集中的文本进行命名实体识别,并将识别出的命名实体作为文本中的属性词。

观点词:我们使用了一个广泛使用的情感词典SentiWordNet来获取情感词的词表,并将文本中与词典相匹配的单词或短语作为情感词。

![]()

受Yan等人工作的启发,我们将AOE任务建模为索引生成任务。目标序列为

![]()

其中as,ae以及os,oe分别表示属性词和情感词的开始下标和结束下标。<sep>用于分隔属性词和情感词。损失函数为

其中O为目标序列的长度。

视觉模态预训练

− 掩码区域模型(Masked Region Modeling,MLM)

![]()

通过随机选取15%的图像区域特征进行掩码,即替换成零向量,该任务旨在预测被掩码的图像区域的语义分布。具体来说,对于解码器的输入,我们用<zero>表示那些被掩码的区域,<feat>表示剩下的区域。损失函数为最小化模型预测的分布和Faster R-CNN预测的分布之间的K-L散度:

− 视觉属性-观点生成(Visual Aspect-Opinion Generation,AOG)

![]()

该任务旨在生成从图像中得到的属性-观点对。我们基于Borth等人的工作,从图像中预测出的形容词-名词对(Adjective Noun Pair, ANP),这种ANP信息可视为图像中的属性-观点对。具体来说,给定一个图像文本对,我们使用一个预训练的ANP预测模型(即DeepSentiBank),并将其预测出的每张输入图片中概率最高的形容词名词对作为AOG任务的目标输出。我们将AOG任务建模为句子生成任务,生成的目标句子即为形容词名词对的文本。损失函数为

多模态预训练

− 多模态情感预测(Multimodal Sentiment Prediction,MSP)

![]()

由于预训练数据集已经标注了图片-文本对的粗粒度情感标签,我们将该标签视为多模态情感预测任务的监督。该任务的目标是结合图像和文本,在解码端预测相应的情感标签。损失函数为

完整的预训练损失

我们对上述介绍的5个预训练任务进行交替优化,总的损失函数为

![]()

下游任务

x.011.png)

我们将多模态属性级情感分析任务的三项子任务MATE,MASC,JMASA作为我们的下游任务。三项下游任务均基于与预训练任务同样的生成式框架建模,具体如下所示:

x.012.png)

其中as,ae表示属性词的起始和结束下标,s表示相应的情感。图2展示了在JMASA任务上的模型框架图。

数据集

预训练任务数据集

采用的是在多模态推文情感分析领域广泛使的MVSA-Multi数据集。该数据集每个样本具有一个图片文本对以及图片文本对上的整体情感标签。

下游任务数据集

采用的是多模态属性级情感分析任务的两个benchmark数据集,即TWITTER-2015和TWITTER-2017。

实验

三个子任务的评估

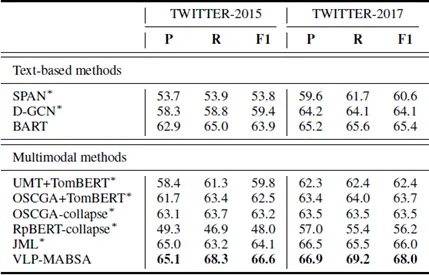

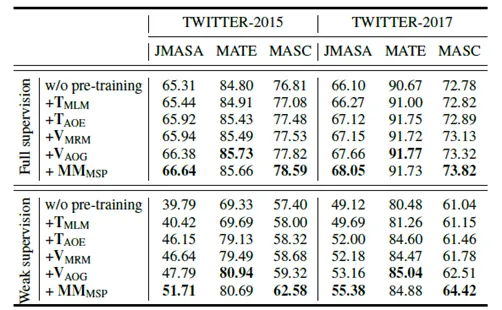

表3 JMASA任务实验结果

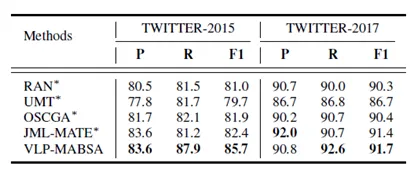

表4 MATE任务实验结果

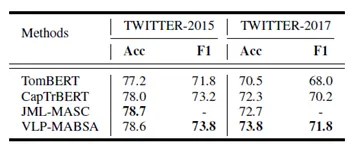

表5 MASC任务实验结果

表3,表4和表5分别展示了在三个下游子任务的实验结果。从表中结果可知,我们提出的预训练模型(VLP-MABSA)在三个下游任务上均取得了较为突出的性能,如在JMASA任务上,相比于目前性能最优的方法JML,VLP-MABSA在TWITTER-2015和TWITTER-2017两个数据集上的F1值分别有2.5%和2.0%的提升。这主要得益于我们设计的面向多模态属性级情感分析任务的预训练任务帮助模型获取了图像和文本模态中重要的客观信息、主观信息以及两者之间的交互。

探究预训练的影响

− 每个预训练任务的影响

表6 各个预训练任务在两个数据集上的实验结果

我们对每个预训练任务进行了消融实验,可以发现随着预训练任务的不断增加,各个子任务的性能均有上升,尤其是在添加任务特定的预训练任务后,性能获得比较大幅度的提升。例如在弱监督的设定下(表6的下半部分),在TWITTER-2015数据集上,当加入AOE任务后MATE任务在F1值上提升了9.44%,加入MSP任务后MASC任务在Acc上提升了3.26%。

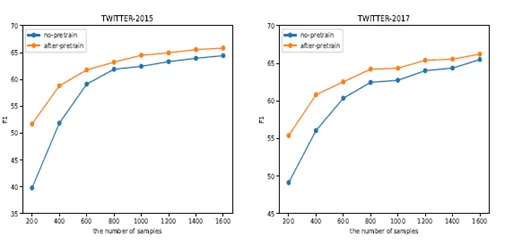

− 使用不同数量的下游数据集微调时预训练带来的影响

以JMASA任务为例,我们比较了当采用不同规模的下游数据进行微调时,使用与不使用预训练的结果。如图3所示,可以发现,当下游数据规模较小时,预训练可以带来比较大的提升,随着规模的加大,预训练带来的影响逐渐减小。这说明我们的预训练模型在低资源标注情况下具有较强的实用性和鲁棒性。

图3 使用不同规模下游数据训练时是否使用预训练的结果比较

总结

在本文中,我们面向多模态属性级情感分析任务提出了一个任务特定的视觉-语言预训练框架。我们从文本,图像和多模态三个角度设计了特定于此任务的5项预训练任务来捕获两个模态中细粒度的客观信息、主观信息以及两者的交互信息。我们在多模态属性级情感分析的三项子任务上开展了实验,结果表明基于该预训练框架的BART生成式框架在三项任务上与当前方法相比取得了领先的性能。同时,该预训练框架能够显著提升多模态属性级情感分析精度,尤其在低资源细粒度情感标注场景下表现出了较大的优势。