用于有表现力语音合成的自监督上下文感知风格表示

作者:Yihan Wu, Xi Wang, Shaofei Zhang, Lei He, Ruihua Song, Jian-Yun Nie

会议:INTERSPEECH 2022

Arxiv 链接:https://arxiv.org/abs/2206.12559

摘要:有表现力的语音合成在风格表征的学习和预测方面仍然面临较大的挑战。从参考语音中提取风格表征或从文本中预测风格标签需要大量的标记数据,获取这些数据成本高,且难以准确定义和标注。在本文中,我们提出了一个新的框架,以自监督学习的方式从丰富的纯文本数据中学习风格表征。进一步地,我们将风格表征作为条件信息加入到一个多风格的语音合成框架中,实现了有表现力的语音合成。我们在有声书生成场景中进行了人工评测,与一般的使用多风格标签的语音合成模型相比,我们的方法在多个数据集、多个说话人上实现了更好的效果。此外,通过使用隐式的上下文相关的风格表征,合成音频在长文本段落中的情感过渡更加自然。

Text1:姨妈这个人就是刀子嘴豆腐心。

Baseline: samples/baseline/1.wav

Ours: samples/ours/1.wav

Text2:等我一下。

Baseline: samples/baseline/2.wav

Ours: samples/ours/2.wav

Text3:一说话就能把人给呛死,几年没见还是这么没脸没皮,也不看看眼下是什么情况。

Baseline: samples/baseline/3.wav

Ours: samples/ours/3.wav

Text4:叶凡也是出于好奇。“你这小子。一说话就能把人给呛死,几年没见还是这么没脸没皮,也不看看眼下是什么情况。” 叶凡给气乐了,当下放弃额头的大包,转而笑骂一声,直接冲对方的胸前来上两拳。“撕嚄!”却疼的自己满嘴咧牙。“你小子是成了钢铁侠呢,还是植了皮的机器人,怎么这么硬?”手晃个不停。“嘿嘿,你猜呢?”庞博挤眉弄眼的,当下咯咯怪笑,难得的一次装牛逼的机会,又是在死党的面前, 当然得争取满分。“你呀……”“我只告诉你一个人哦。”

Baseline: samples/baseline/4.wav

Ours: samples/ours/4.wav

更多音频样例请参考网页。https://wyh2000.github.io/InterSpeech2022/

关键字:有表现力的语音合成, 自监督学习, 深度聚类, 表示学习

一、动机介绍

1.1 背景介绍

尽管TTS模型可以合成干净、高质量的自然语音,但在一些复杂的场景中,它仍然存在着韵律模式过于平滑的问题,如有声书合成场景。由于情绪及其基于上下文的变化是难以建模的高级特征,这直接影响了语音整体的韵律和说话风格。与持续时间、音高和能量等低级声学特征不同,高级声学特征的建模在这些复杂场景更具有挑战性,也极为关键。

1.2 有表现力语音合成方法

为了合成有表现力的语音,通常有两种方法:

使用参考语音的无监督方法

使用风格标签的有监督方法

其中,使用参考语音的无监督训练方法需要依靠大量的

1.3 本文方法

在本文中,结合以上两种方法,我们提出了基于自监督学习的上下文相关风格表征学习方法,利用自监督学习方法从纯文本数据中学习风格表征,并作为条件信息加入到语音合成模型中。

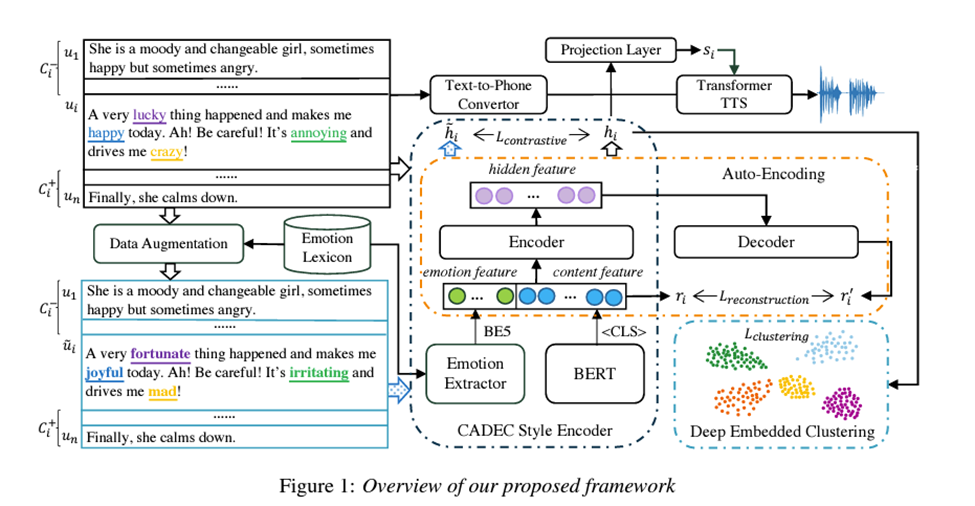

首先,我们采用对比学习的方法,通过区分风格相似和不同的语句来预训练风格表征。为此,我们通过使用情绪词汇库将一个情绪词替换为一个类似的词来创建一个风格近似的话语。使用风格相似的话语作为正例,所有其他不相似的话语被视为负例。

其次,我们对风格表征空间中的训练样本进行聚类,将深度聚类损失、重构损失和对比损失最小化。

最后,我们从大量无标记的纯文本数据中学习风格表示,构建文本风格隐空间,指导语音合成中有表现力的音频的生成。

二、模型框架

Stage 1:基于数据增强的对比学习

我们提出了基于情感的数据增强方法。为了能够将语句 扩展为风格相近的语句,首先,我们将句子分为更短的片段,在每个片段中提取情绪强度最强的词,并使用其同义词进行替换。如图一所示,我们将原句“A very lucky thing happened and makes me happy today. Ah! Be careful! It’s annoying and drives me crazy!”切分为两个片段,在每个片段中选取情绪最强的前两个词进行替换,即,将“lucky” 替换为“fortunate”,“happy” 替换为“joyful”等。将长句子分为较短片段的目的是:充分考虑句子中不同片段的情绪变化,避免只关注某一部分的主要情绪。为了结合不同的上下文和语意,我们使用预训练模型BERT提取本句及上下文的语义特征,以及一个额外的情感词典提取显示情感特征,并使用编码器共同编码语义及情感信息。

参考simCLR,在每个数据集上,我们使用风格相似的语句对作为正例,其余语句对作为负例,使用对比学习损失优化模型。

Stage 2:结合自动编码器的深度嵌入聚类

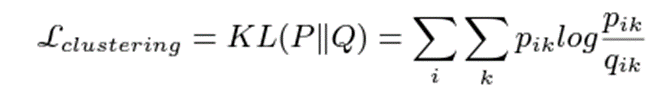

为了进一步优化风格表征的分布,我们使用结合自动编码器的深度嵌入聚类方法,对模型进行进一步优化。聚类损失函数定义为:

其中, P 是Q 的目标分布。

此外,由于这种聚类会造成原有的特征空间的扭曲,削弱了隐式特征的表现能力,我们加入了自动编码器并结合重建损失对特征空间进行进一步约束。因此,在Stage 2, 我们使用三个损失函数对模型进行共同优化:

![]()

TTS stage:结合风格表征的语音合成

Transformer TTS 使用基于Transformer 的框架,实现了高质量的语音合成。我们将Stage 1, Stage 2 得到的风格表征作为条件信息加入到Transformer TTS中,实现更具表现力的语音合成。

三、实验结果

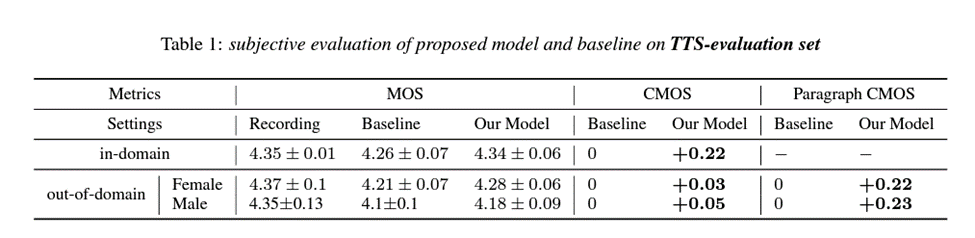

我们在有声书生成的数据集上进行了实验,该数据集分别由一个男生和一个女生使用富有表现力的方式用中文进行录制。我们将我们的方法与基线方法(使用预测的风格标签作为条件信息的语音合成模型)进行比较,使用Microsoft UHRS crowdsourcing platform 进行了人工评测。参与人员被要求更关注说话风格和表现力。我们分别测试了MOS(Mean of Opinion Score),CMOS(Comparative MOS)和 paragraph CMOS。实验结果如下表所示:

由表1可以看出,与基线方法相比,我们的方法在MOS和CMOS得分上都有比较明显的提高,说明我们的方法实现了更好的音质和表现力。更明显的,我们的方法在 paragraph CMOS得分上表现出了明显的提升,说明在长段落生成时,我们的方法实现了更好的表现力和风格连贯性。

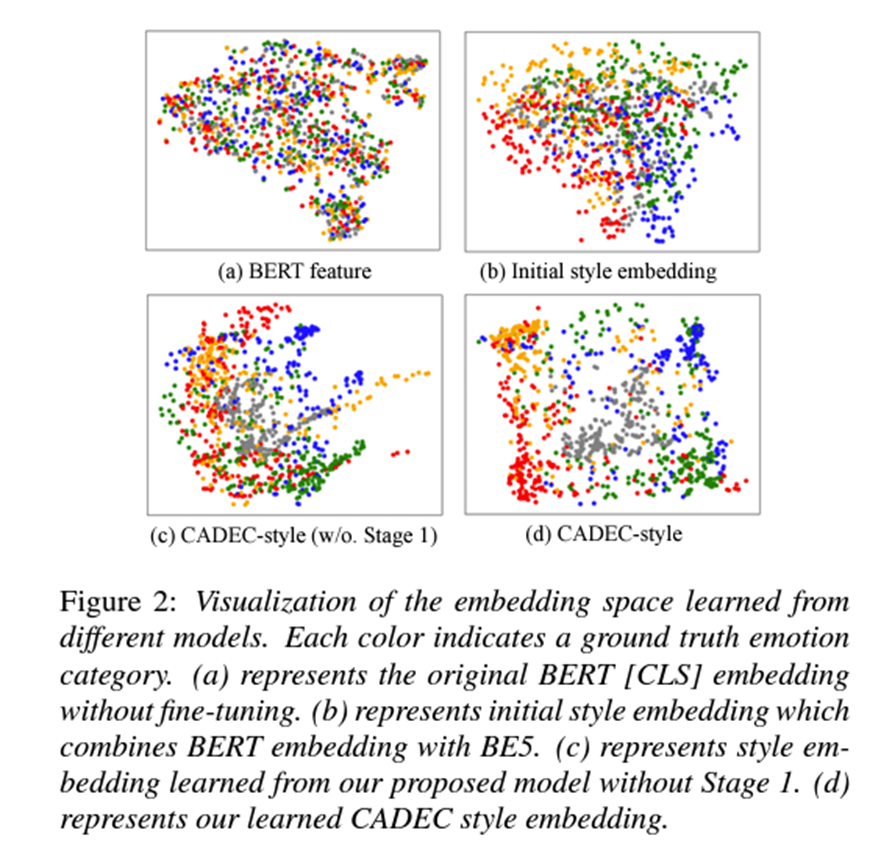

此外,我们对得到的风格表征进行了分析。我们使用t-sne 对得到的风格表征进行了可视化分析。实验结果如下图所示:

由图中可以看出,去除 Stage 1 会造成表征空间的重叠,影响聚类的效果。此外,我们使用风格表征进行情感分类,结果发现,去掉Stage 1 和上下文信息都会造成准确率的下降。

四、总结

在本工作中,我们提出了一个全新的上下文相关的风格表征自监督学习框架,用来进行无标注的有表现力语音合成。我们提出的模型有以下优点:

作为一种基于自监督学习的文本风格表征模型,它可以从大量无标注文本中学习,不需要额外数据和标注。

将上下文信息和风格信息结合,并编码在连续特征空间中,进而实现长段落语音合成的自然表达和情感过渡。

未来,我们将使用更多的文本语料库来增强文本风格表示,以获得更好的准确性和鲁棒性。此外,我们将进一步探索更稳健的从文本到声学特征空间的映射风格嵌入,并以灵活可控的方式引导合成语音风格。

作者简介

吴宜函(第一作者)

中国人民大学高瓴人工智能学院博士二年级在读。主要研究兴趣包含情感计算,语音合成,机器翻译等。她最近的工作发表于语音领域顶会INTERSPEECH上。

宋睿华(通讯作者)

中国人民大学高瓴人工智能学院长聘副教授。她近期的研究兴趣包括人工智能的文本创作、自然语言的多模态理解和多模态对话系统。宋睿华博士是具有国际影响力的科学家,在国际会议和期刊上已发表了学术论文80余篇,拥有25余个国际专利。她担任着多个国际一流会议(SIGIR, CIKM, EMNLP等)的领域主席、资深评审和评审,国际期刊(Information Retrieval Journal和Foundations and Trends in Information Retrieval)的编委。